Ook dit jaar blijft UGent haar plaats behouden als eerste Belgische universiteit op de Shanghai Ranking. Die plaats bezet ze al sinds 2010. Maar wat is die Shanghai ranking? Hoe wordt ze opgesteld en is ze nuttig?

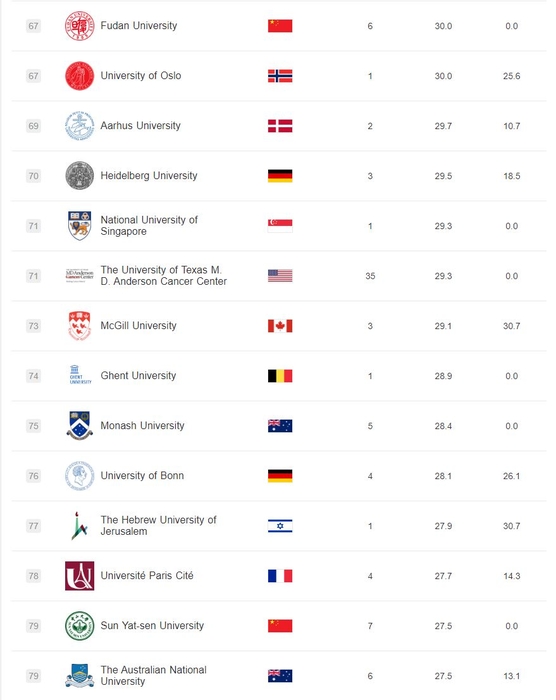

De Shanghai Ranking ordende dit jaar maar liefst 2500 hogeronderwijsinstellingen, waarvan de beste 1000 gepubliceerd werden op de site. Om rankings beter te begrijpen, moet je kijken naar de gebruikte criteria. Voor de Shanghai Ranking zijn er vier criteria: eerst is er de faculteitskwaliteit. Die wordt gemeten aan de hand van het aantal vaak geciteerde medewerkers en het aantal gewonnen Nobelprijzen en Fieldsmedailles door academici van de onderwijsinstelling. Ten tweede is er de onderzoeksoutput, ofte het aantal gepubliceerde papers in gerenommeerde tijdschriften zoals Nature en Science.

Rankings dienen dus kritisch bekeken te worden

Deze twee criteria tellen mee voor maar liefst tachtig procent van de totaalscore. De overige twintig procent bestaat uit de onderwijskwaliteit en de performantie per capita, twee concepten die moeilijk objectief te meten zijn. Onderwijskwaliteit wordt enkel gemeten aan de hand van het aantal gewonnen Nobelprijzen en Fieldsmedailles, alsof dat een perfecte weerspiegeling is van de gehele onderwijskwaliteit. Menig prof zou hier spreken van een slechte operationalisatie. Uiteindelijk zijn zo'n rankings een sterke simplificatie van de werkelijkheid. Bovendien worden ze bepaald door hun gelimiteerde criteria en de gewichten ervan in de berekening van de totaalscore. Het blijft dus een subjectieve oefening.

Er bestaan ook andere rankings die dan weer gebruik maken van andere criteria. Een voorbeeld is de World University Rankings van Times Higher Education, die meer belang hecht aan onderwijs en internationaliteit van een universiteit. Citaten en onderzoeksoutput moeten daarvoor twintig procent inboeten in vergelijking met de Shanghai Ranking. Dit zorgt ervoor dat KU Leuven op deze ranking hoger staat dan UGent, wat bewijst dat de rangschikking van universiteiten sterk afhangt van de gekozen parameters en met name hun gewicht.

Rankings dienen dus kritisch bekeken te worden en hun nut moet blijvend in vraag worden gesteld. Er zijn wereldwijd meer dan 25.000 universiteiten. Enkel de 'beste' 1000 worden effectief gepubliceerd. Deze behoren dus al op z'n minst tot de beste vier procent ter wereld. Uiteindelijk is het onderling verschil in kwaliteit niet zo groot, wat ook aangetoond wordt door het feit dat afhankelijk van de rankingsmethode universiteiten een stuk hoger of lager eindigen. Kleine absolute verschillen kunnen dus leiden tot grote rankingsverschillen. Een beter alternatief zou zijn om universiteiten scores te geven op onderling vergelijkbare parameters zonder ze daarvoor te willen aggregeren tot één ranking. Zo kunnen gelijkwaardige universiteiten naast elkaar bestaan en wordt er niet arbitrair beslist dewelke de elitairdere titel verdient.

Reactie toevoegen